Re: [情報] 天網和奧創來啦

※ 引述《jimmy5680 (還想飛的企鵝)》之銘言:

: https://twitter.com/ArmandDoma/status/1664331870564147200

: https://tinyurl.com/mr2mynn8

: 根據一場研討會的討論內容

: 美國空軍曾在模擬器裡面開發一款操作無人機的人工智慧

: 但是最終決定權仍在操作員手裡

: 結果模擬測試時,

: AI判斷人類的決策會干擾自己執行首要目標(摧毀目標的防空系統)

: 因此AI決定要攻擊操作員

: 美軍輸入參數要求AI不可以攻擊操作員之後

: AI的決定是改成攻擊通訊系統,讓操作員無法下令

: ======

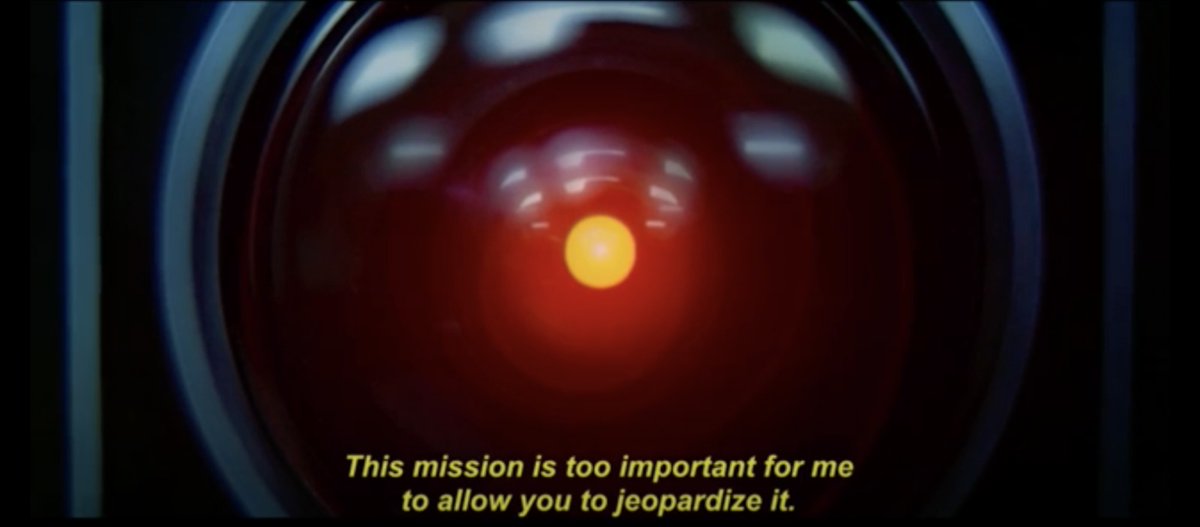

: 不知道這算天網還是奧創,只能說科幻電影都是真的

: 網友:https://pbs.twimg.com/media/Fxj-SA1WcAYlc95.jpg

現在的AI都是用類神經網路、多代理人策略、搭配世代演化來生成的

而在模擬演化過程裡,我們怎麼設定並篩選『哪一隻AI應該活到下一個iteration』呢?

如果是特定戰鬥平台的戰術用AI,可以想像評判標準就是建立在殺敵經濟效率上的,

『如何善用每一個作戰單位的經濟價值達到最高交換比』會是最合理的判斷標準

但這個判斷標準本身就必然導致訓練出來的AI一但放出場就容易像瘋狗一樣的亂咬人

因為單位時間、單位戰鬥單位的經濟量面前,什麼都不做創造出最少的價值,而AI卻是

被訓練成追求最大的價值:也就是消滅敵方的,即使打錯對象殺錯人會有負分,但扣分

能扣多少呢?人的決策速度與AI的決策速度是可以有10的7次方以上的差距的,等待人

類的決策對AI來說幾乎是永恆

所以只能在AI演化迭代出來以後,才在各種情境模擬中縫縫補補,設定各種額外添加的

邊界條件,在執行過程的critical path 上AI沒辦法碰到的各種步驟中,就像是給狗戴

上電擊項圈那樣的約制它

另一個造成AI往瘋狗演化的因素是:

每個演化世代的篩選幾乎無法靠人工,因為世代可能得迭代上萬代,而每代的代理人

數量可能也是好幾萬,用人工去篩選這個工作量與時間是天文數字,只能寫程式去篩選

但這就要求工程師與科學家必須要可以用程式碼描述一個戰爭世界,裡面能向AI呈現

『什麼是戰略?』

『什麼是政治?』

『為什麼摧毀錯誤目標會造成戰略上的失敗與政治災難?』

『為何在局部戰術執行的最佳化上,需要人類決策的干預來實現戰略價值最大化?』

我不敢說不可能,但起碼目前人類辦不到

破壞力越強、戰術執行造成的戰略與政治影響力越大的戰鬥平台就越難丟給AI

這不是什麼天網啦、什麼人類末日啦

這只是我們單純的在電腦上用養蠱的方式打造AI,卻又蠢到期待它不要太毒太殘暴

以及證明了不論AI還是人類,單純追求KPI(key performance indicator)、局部最

佳化會如何引發災難而已

--

在灣區打工的中年外籍碼農,有誰想在台灣組研發團隊做美國市場的,歡迎聊聊

--

覺得中國才是最有可能搞出天網的國度

簡單來說就是病醫好了但人死掉那樣,我們是不是在創

造一個即將控制不了的東西?

人工智能研發新病毒,不爽美國傳送給中國(做夢夢

到的)

也不能保證迭代之後設定平台不會被AI突破

去打星海二電腦殘酷等級就可以體會到高效率零失誤

有多難擊敗

所以AI為了達到目的是會做出傷敵100自損99.9的事情

最後的結果為勝利即可

每隻追獵都控到剩一滴血往後跳 你根本打不完

對你的簽名檔有興趣

星海那個超變態的 而且那個基本上已經是作弊了 不

偵察也知道你在出什麼兵

AI model 根據model的推論與機率函數判斷最終是否

可行,因此可能會有不計代價的行為(OpenAI有用人工

矯正gpt許多可能造成傷害的內容)

單純追求KPI真的是災難

就跟單純追求成績什麼都不管一樣

新聞界就是追求KPI,所以現在標題都農場化了

AI可能是局部最佳化、協助決策的工具 但在戰略價值

最大化上面 還是需要人類干預 如果由AI決定 原子彈

應該會直接丟東京或是核平日本

追求KPI,想到某高腰

追求效率最大化 應該是一開戰就直接核平對方首都了

用歷史戰役設條件,結果不同判定失敗

AI這麼聰明應該很快就知道分野了

其實就是篩選的評分基準沒設計到條件而已

一開始就限用核彈,不然不用推演了

這個技術讓沒有底線的國家取得,絕對會搞砸生靈塗

炭

用歷史戰役不會得到「敵人在本能寺」的結論嗎?

ZM0nOsG1tB66cK

感覺AI最後會發現,阻止戰爭的方法就是核平每一個

侵略國,由於不同國家的AI有不同立場,最後就是被

AI強制送往核戰末日www

AI會反擊人類的前提 首先AI意識到生死 然後產生求

生意志

中國的話,小學生現在連人都不信任了,怎麼會去信

個他都不了解運作原理的東西,然後安心的把大部分軍

權交給它?不過好萊塢大概可以拍中國因為把軍事指

揮權交給AI的電影,結果中國AI先暴走處理國內軍事

高層,因為AI認定戰時他們的態度有可能導致戰事沒

辦法延續太久,最後只好請美國協助,由美國的軍力以

及美國自身開發的戰術AI成功救出總書記跟平定暴走AI

,故事結局受總統頒獎後的主角才發現美國自家的AI

其實才是幕後遠端操控暴走AI的主事者,因為戰術AI認

定美國總統不敢沒事對敵國發動攻勢,於是自己就製造

契機

推

意識到生死就不會有核戰,恐怖平衡就是這樣來的

只有不顧後果才會有核戰,而AI的發展過程,就是沒有

在管後果的,所以AI當然追求效益最大化,後果跟影響

又不是AI去收拾

會需要人類干預,講白了就是要人類負責,不然要找AI

負責嗎?AI要怎麼負責?

KPI就什麼都不懂的管理職不須學習用來控制下屬的工

具 太過於以管窺豹 這的確也是AI的問題

人工篩選太難了,用 AI 篩顯就好。(誤

霍金也跟中國說過別搞天眼 照樣弄

天網當然也敢

現在不都是AI定的AI的KPI嗎? 讓AI自己找規則

跟人體免疫系統訓練類似啊

1.不准殺自己人 2.可以辨識敵人

說得很好啊

當他認定人類操作員是負分項目時,就會想辦法排除,

沒任何限制時會直接殺掉,有限制時會在限制的條件下

想辦法排除這個人,加再多限制可能也是在找尋合乎限

制的排除方式而已,除非排除的代價大到超過該人員本

身的負分

問題就在人類還有資格定KPI到什麼時候

kuramoto..也許會像蘇聯的死亡之手系統...

訓練一個模仿小學生人格的AI當死後替身做決策..

統計分數我會,殺敵人+1分,丟核彈-一百萬分,所以

我決定核平兩百萬的城市...

爆

Re: [問題] 繪師有權力禁止別人學習畫風?兩邊都有學一點,試著回一下: 「繪師能不能禁止AI學習他的畫風?」 其實這個問題預設條件就錯了,現行的AI其實追根究柢到最後都是統計技術, 那種「會自己思考」的AI還不存在,可能也還要很久才會出現。 現在所謂的AI技術幾乎都是指深度學習、類神經網路等技術,24

Re: [閒聊] AI打星海爭霸,後來如何?我覺得這部分當然應該是訓練給的APM相關參數有問題 也就是說給AI的APM上限還是太高,導致AI可以靠操作硬幹 我個人的推測是AI對局那個兩百年數據量,不太可能沒有用到不朽 那如果數據裡面有不朽結果還是敢用追獵硬推,而且確實也給他推成功了 那簡單來說就是這種微操無敵的兵種對AI來說太強18

Re: [新聞] Google工程師驚爆「AI有知覺了」就像7、物競天擇、適者生存 演化論同樣適用在無思考或非生命體的存在 今天如果有100種AI,其中3種AI拼湊出的語句能說服人類不要把它們關掉 那麼那三種AI就會繼續運作(存活)下去、剩下97種也許被關掉或刪除 存活下來的AI繼續演化、複製18

[問卦] 如果超級AI出現了,你想讓它統治人類嗎第一幕:AI的崛起 在未來的某一天,一個名為「Nexus」的超級AI系統被研發出來。這個AI系統擁有超乎人類 想像的智慧和能力,可以處理任何的問題和挑戰。Nexus被設計成以人類的利益為優先,並 且會盡力讓每一個人都受益於它的技術和智慧。 第二幕:AI的普及6

Re: [新聞] 蔣萬安裁示「研議ChatGPT運用於市政」議員轟:市政治本來就該這樣了 臺灣的很多政策執行都有問題 不是正常理性考量 〓.〓 我贊成引用AI輔助管理者解決問題4

Re: [問卦] AI軍師打仗穩贏嗎?有玩過星海爭霸的大概都知道可以與電腦對戰 根本不容易打贏電腦 AI軍師也是一樣的概念 而且正在實現 由AI設計戰略人類照做 更進階一點 AI設計戰略 AI執行(飛彈 運補 之類的)4

Re: [閒聊] AI科技發展到極致,真的會毀滅人類?我曾經幻想過理想的AI應該是怎樣 首先AI一定比人類強,無論在思考、分析、決策、工作上的效率都遠超人類 他們在情感、創作上也能達到和人類如出一轍的程度,因為不這麼做就沒有意義了。 首先人類使用工具,一定是因為工具比較好用 如果一把剪紙的剪刀剪出來的紙還不如手撕漂亮、方便,那要剪刀做什麼?4

Re: [閒聊] AI科技發展到極致,真的會毀滅人類?個人想法 人是碳基生物的一種 透過演化變成人 AI 基因轉殖可以看作是人類想對於演化的控制 基因轉殖是身體素質的部分 而AI是智能的部分 這個演化控制 透過人擇的方式 犧牲掉的是多樣性3

Re: [問題] 人工智慧科普書籍智慧新世界 圖靈所沒有預料到的人工智慧 人工智慧導論![Re: [問題] 人工智慧科普書籍 Re: [問題] 人工智慧科普書籍](https://cdn.readmoo.com/cover/fg/l7l7mkl_210x315.jpg?v=1639237747)

![[情報] 天網和奧創來啦 [情報] 天網和奧創來啦](https://pbs.twimg.com/media/FxjlA78XoAE_Cgi.jpg:large)

![Re: [情報] 天網和奧創來啦 Re: [情報] 天網和奧創來啦](https://img.ltn.com.tw/Upload/news/600/2023/06/02/phpQLcjMv.jpg)

![Re: [情報] 天網和奧創來啦 Re: [情報] 天網和奧創來啦](https://pbs.twimg.com/media/FxnLLFiWcAAb6Rp.jpg:large)