Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好

※ 引述《ykjiang (York)》之銘言:

: 從最基本的原理來說,光達跟雷達就是用來測距,理論上只有一維的資訊

: 三維的部分是經過一些設計、運算後得到的

: 反而鏡頭得到的一開始就是二維資訊,然後可以經過運算得到三維的資訊,

這邊看完,我的感想只有“供三小?”

雷達與光達在原理上是利用掃描的方式,取得距離與向量,本質上資料的維度就是大於二維了。

是什麼時候變一維的?如果要這麼瞎扯,那鏡頭裡的CMOS一次也只能讀一個cell的資料,一樣得要逐個掃描才能得到二維影像(這個就是所謂的果凍效應的成因),

照你的說法,鏡頭不也一樣是一維的?

: 特斯拉更進一步從中取得四維資訊(多的那維是時間軌跡預測)

這邊也不知道在供三小

在半個世紀前,雷達後處理技術就已經發展出利用比對前後時間目標的變化,預測目標未來位置,

並且持續追蹤的技術。甚至還有類似合成孔徑雷達(SAR)那種利用時間與位移積分,

利用二維掃描形成3維雷達影像的技術。

而利用都卜勒濾波技術,甚至不需要比對前後時間的資料,就能直接得到目標的速度,

在半個世紀前,雷達就能直接利用都卜勒測速,外插推估目標的未來位置。

但也沒人講雷達是四維資料的探測器。

而特斯拉的前鏡頭並沒有構成立體視覺,就算加上時間預測,也只能構成2.5D,

(三個定焦鏡只能利用影像模糊的程度大致判斷距離),這也是特斯拉自動駕駛在視覺深度一直為人所詬病的地方。

: 以目前的技術:

: 距離方面,光達的精度比較高

: 平面部分,鏡頭的精度較高,然後鏡頭還可以判斷顏色這個重要資訊

: 以自動駕駛而言,兩者的精度都超過人眼了

: 所以關鍵還是在 AI 等其他方面

無腦特粉才會覺得只靠鏡頭和AI就行

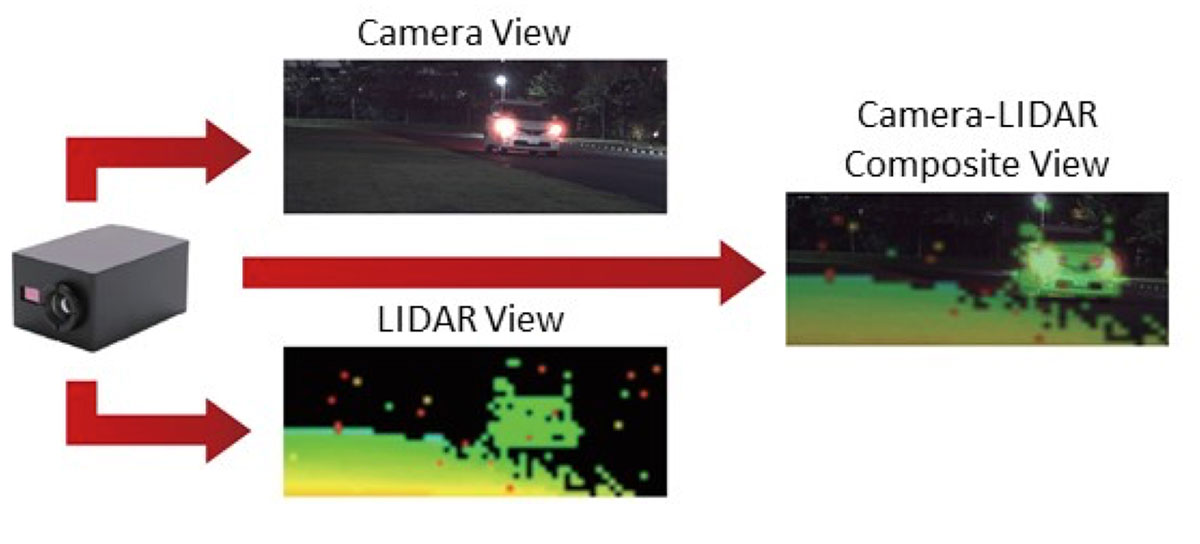

真的在搞自動駕駛的,在研究的是怎麼做多感測器的融合。

https://global.kyocera.com/ces/img/sensing-technology/sec11_img03.jpg

: ※ 引述《airforce1101 (我不宅)》之銘言:

: : 影像、雷達、光達不太一樣,我把影像與雷達、光達拆成兩類好了,影像對於訊號處理來

: : 說屬於二維陣列,但是雷達與光達可以帶回三維的目標資訊,雷達就是低頻段的光,因頻

: : 率特性不同,所以適用場景不同,光達的脈衝時間很短,所以較於雷達相比,對於相同目

: : 標,可以帶回更高精度的資訊。

: : 光達的領域上有關延展性目標,可以參考K. Granstrom, M. Baum, and S. Reuter 所著

: : 的這篇文章 Extended object tracking: Introduction, overview, and application.

: : 在AI輔助下,或許環境良好下影像能做到光達能大多數能做的事,但某些判斷影像與光達

: : 先天上的差距還是存在。

: : 其實也好奇,傳感器與影像間的關聯是否讓AI找出並學習其特徵向量,有待高手解答了。

--

亂餵流浪狗的人其實和渣男沒什麼兩樣

一個是讓狗以為自己是有主人的狗,一個是讓人以為感情有了歸宿

但都只是做半套不想完全負責而已

--

特斯拉也有雷達OK 不是只靠鏡頭

我看完你寫的感想也是公三小?!?

特斯拉的前雷達分辨度大於7度,在50公尺外並排行駛

的兩輛卡車,特斯拉雷達上也會辨識成同一個物體。

04/09 02:47 特斯拉用的是三個焦距不同的定焦鏡 對同一個物體只會有一個鏡頭有較清晰的影像 這種鳥玩法是弄不出立體視覺的。

而特斯拉用了這種等級的雷達,雷達測距資料與影像資

料的融合,基本上和用AI預測擲筊結果差不多吧

螢幕顯示一輛車 並不代表他就只能看到一輛 只是你

看的越細需要的電腦資源就越多 那有沒有這個必要

我認為特斯拉比較著重在視覺辨識,雷達只是輔助

我覺得不太需要下定論啦 如果真覺得光達終勝那可以

特斯拉用三顆定焦鏡的鳥玩法,反而增加了電腦運算的

買Mobileye股票 應該會賺翻

需求量。光達+鏡頭,關聯性演算法的需求可以低到只

用單晶片距離,但是特斯拉就要用到礦卡級的處理器。

但我記得NIO用光達卻配了4顆N牌高階處理器耶

人家NIO要搞的ADAS,是要直接衝Level 4,才要開發這

個規模的硬體。可沒像特斯拉還要求車主雙手不能離開

方向盤呢。

另外,用NIO沒像特斯拉小器的使用低解析度的攝影機

,影像串流處理的量本來就比較高,把tops去除pixel

數量,特斯拉用的運算資源還比較高勒。

三個定焦鏡是指三個不同焦距的鏡頭?

是的話對同一物體可以同時準焦吧

問題是鏡頭內的影像不會只有一個物體,而且這三顆鏡頭的焦距範圍各差了100公尺 相當於戴著單筒望遠鏡,還傻到要建立兩眼立體視覺一樣搞笑

只是成像時物體大小會不同 不會只有一個準焦

不會有你說的一個鏡頭清楚 其他模糊的情況

到底在公三小,講的好像特斯拉沒有要衝Level4一樣

你要針對物件辨識、車輛辨識、道路辨識好像不用運

算資源一樣

你好像分不清焦距跟對焦距離的差別,特斯拉用了三

顆不同焦距的鏡頭,但是這三顆鏡頭的對焦距離基本

上可以視為泛焦。加上三顆鏡頭的位置並不重疊,是

完全可以計算出深度的,可惜的是並不是全畫面都算

得出來。

你講的不就我上面已經講過的2.5D?

而且特斯拉前向的鏡頭總共有五個,另兩個在側前方

側前方那兩個鏡頭的規格是完全一樣的

https://qph.fs.quoracdn.net/main-qimg-18ea7bf48a6f7dfdce9e384c2ef80840

兩個側前方的鏡頭,和前方鏡頭視角重疊的範圍只有十幾度,而且還不是在車的前方。 這個分配是要怎麼弄出兩眼立體視覺??

※ 編輯: ewings (42.76.142.6 臺灣), 04/09/2021 04:00:51你對緯度的定義有問題,兩顆鏡頭只要能看到同一個

物體,就必定可以辨識出三維的位置。可辨識範圍不

會影響維度。而且這三顆鏡頭只有一顆是長焦的,你

的望遠鏡舉例根本不合邏輯。

不知你怎麼看出十度,而且只要那兩個重疊夠大就夠了

你忽略了wide forward camera跟main forward cam

era的重疊區了。

十度應該是廁後方那兩個鏡頭

重點是Tesla這樣的鏡頭配置行之有年了,

要真有如此低級的設計錯誤發生,早就更正了

查了一下Tesla 3D視覺主要是靠正前向的那三個鏡頭

可行的原理如 kmlvli84 說的

只要兩個鏡頭拍出的同一個物體有不同位置或大小,

理論上就能估算出距離

不同大小,可以因為視角範圍不同或焦距不同造成的

好了別吵 來看資料 Tesla其實用單鏡頭就能判斷距離

實測遮到剩一個鏡頭還能在路口轉彎

無腦特黑的最高表現?理性討論不行嗎

不懂就虛心求教 整天扣人帽子

嗯嗯 口氣很大水準很高 哈哈哈哈哈

供三小 然後咧 其他車廠現在在幹嘛

單鏡頭理論上可行,但是特斯拉目前的鏡頭規格有風險

...

換鏡頭分分鐘的事情而已 目前特斯拉鏡頭解析度不高

不光是鏡頭的問題,早些年前晶片設計接收鏡頭影像格

式的接面可能也不堪使用。

現在的鏡頭不會只丟純影像的內容給晶片,還會伴隨其

他感測資料,然後車用鏡頭這幾年吃記憶體頻寬越來越

恐怖,車用壓縮也不太可能用lossy的方式,不過這看

車廠對於風險的拿捏。

那篇果然沒內容

你太小看軟體了

感覺你是在硬體廠,現在軟體單鏡頭就能看深度了。

看物體大小加上時間就能判斷

上面推文很多人寫了,而且這是潮流

謝謝你帶來歡樂

做硬體的怎麼不知道景深這件事.....

3

笑死,你又把你自己的妄想拿來當證據了,啥“初代光達”! 20年前,連名稱都還沒統一叫Lidar時,就已經在研究使用光電感測器陣列直接生成三維影像了, 一開始研究光達的時候,就有人從雷射全像技術出發,從來沒有你想像的“一維”Lidar : : : 你講的應該是 Rolling Shutter 造成的果凍效應,![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://pic3.zhimg.com/v2-662fc50c422e039867385d43feb2bacb_l.jpg?source=172ae18b)

7

提到光達,沒有人會扯到雷射全像術吧 維基百科介紹 LiDAR 原理時附的動畫如下: Velodyne 出的,早期被用於電動車的 LiDAR ,Waymo 還在用的,結構如下:![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://upload.wikimedia.org/wikipedia/commons/4/4b/Effigy_mounds_lidar.jpg)

1

笑死,光達輸出的資料從來就是三維的,只有一維的叫雷射測距儀。 如果是更早之前還在用LADAR為名的時代,還有更多是利用全像原理,用相位差生成三維資料的技術。 對系統來說,不過感測器是用甚麼原理,輸出的資料格式如果是三維的,那就是三維, 有差別的只是更新率而已。 而光達輸出的一直都是三維資料,即使是平面光達,也是三維資料降維。6

我沒說光達最後的輸出資料不是三維,我只是說初代的光達是用一維的雷射測距,經巧 妙設計後得到三維的資料 : : 你講的應該是 Rolling Shutter 造成的果凍效應, : : CMOS 會採取 Rolling Shutter 有很多因素,例如為了功耗、快門速度、共用元件等 : : CMOS 後來也有 Global Shutter 的設計2

OK, 以雷達波的特性,的確如你說的,可以一個雷達波出去,同時有多組天線接收 這部分跟光達有差異。 : : 你講的 CMOS 果凍效應,不是 CMOS 的本質,而是數位化後,要將資料放在記憶體, : : 從記憶體讀取時有先後順序,這基本上是電子式的掃描,跟前面的機械式有差距。 : 這邊也是看不懂你在講三小![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.technews.tw/wp-content/themes/twentytwelve/library/images/logo.gif)

3

雷達基本上是機械動作在掃描 初代的光達也一樣,最新的發展小型化後,有搞陣列方式同時發射好幾組雷射,不過 解析度還是個問題 你講的 CMOS 果凍效應,不是 CMOS 的本質,而是數位化後,要將資料放在記憶體, 從記憶體讀取時有先後順序,這基本上是電子式的掃描,跟前面的機械式有差距。1

還是不曉得你在供三小 從雷達誕生以來,也從來沒出現過你口中的“一維”雷達 拿二戰裡的德國Lichtenstein雷達來說好了,雷達發射天線是固定在飛機的機首, 也沒有任何的機械機構讓天線搖動或轉動。![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.laserfocusworld.com/files/base/ebm/lfw/image/2020/03/2004LFW_jh_1__2_.5e834778af184.png)

7

直接看實際例子不就好了 在機車海的國家打開FSD 都能正常自輔駕 實際例子有什麼還能質疑的嗎![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.youtube.com/vi/j3n1xBvYkP0/mqdefault.jpg)

9

目前應用的雷達跟光達在量測數據上還是有些不同 [雷達] 參考這篇文章![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://i.imgur.com/AInOO4Db.jpg)

18

首Po這個youtuber將FSD AI看到的畫面結合實際行車畫面 有幾個亮點, 你去觀察對向車道,或是更遠處都可以發現AI都可以清楚知道車子位置在哪 換句話說,FSD用了鏡頭就可以模擬光達的距離偵測了 這個技術已經被特斯拉提出為專利![[分享] 特斯拉FSD beta 來比眼力有沒有比AI好 [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.youtube.com/vi/qRjY55ELYnc/mqdefault.jpg)

26

[電車] 沒有雷達的特斯拉正式出海,為何馬斯克、標題連結: 沒有雷達的特斯拉正式出海,為何馬斯克、Toyota發展自動駕駛都押注鏡頭技術? 內文: 特斯拉宣佈捨棄雷達近一年後,沒有搭載雷達的Model 3、Model Y如今也正式出海,銷往![[電車] 沒有雷達的特斯拉正式出海,為何馬斯克、 [電車] 沒有雷達的特斯拉正式出海,為何馬斯克、](https://bnextmedia.s3.hicloud.net.tw/image/album/2021-02/img-1613969137-54717@900.jpg)

9

[討論] 光達與毫米波雷達 自駕技術的未來之戰今天網路有一位曲博士分析了未來自駕技術所使用的雷達與光達的差異 並大膽分析特斯拉未來自駕技術的選擇 因為影片很長相信大多數人不會看完 所以總結一下![[討論] 光達與毫米波雷達 自駕技術的未來之戰 [討論] 光達與毫米波雷達 自駕技術的未來之戰](https://img.youtube.com/vi/bPaSqgg7aws/mqdefault.jpg)

11

Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好從最基本的原理來說,光達跟雷達就是用來測距,理論上只有一維的資訊 三維的部分是經過一些設計、運算後得到的 反而鏡頭得到的一開始就是二維資訊,然後可以經過運算得到三維的資訊, 特斯拉更進一步從中取得四維資訊(多的那維是時間軌跡預測) 以目前的技術:![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.youtube.com/vi/tEO2X7i9MEw/mqdefault.jpg)

1

Re: [討論] ACC撞防撞車是不是設計太智障我的興趣是開發車輛自動駕駛的程式。 根據我不專業的瞭解。 ACC 無法判斷靜止的車輛,是一件很匪夷所思的事情。 當然,我是不清楚市售車的 ACC原理跟我們軟體的原理是否一樣。 但是,從程式的角度來看, ACC 沒道理對靜止車輛無感。 如果你是像特斯拉用純影像辨識的方法,照理,不論是行進間車輛、靜止車輛,![Re: [討論] ACC撞防撞車是不是設計太智障 Re: [討論] ACC撞防撞車是不是設計太智障](https://i.imgur.com/TZB9Am8b.jpg)

![[閒聊] 福斯車系反倖存者偏差 [閒聊] 福斯車系反倖存者偏差](https://i.imgur.com/Er5M8TPb.jpeg)

![[閒聊] 特斯拉車重怎麼做到輕量化? [閒聊] 特斯拉車重怎麼做到輕量化?](https://img.youtube.com/vi/JO6C6Yw4Mxk/mqdefault.jpg)

![[問題] 新款ev6 2025 [問題] 新款ev6 2025](https://img.youtube.com/vi/WGJU4v4TWK8/mqdefault.jpg)

![[問題] 乙式保單請益 [問題] 乙式保單請益](https://i.imgur.com/Toh5gGRb.jpg?fb)

![[問題] Altis後車廂大小 [問題] Altis後車廂大小](https://img.youtube.com/vi/X8BT7AtjwTM/mqdefault.jpg)

![Re: [問題] 低速過彎輪胎會亂叫 Re: [問題] 低速過彎輪胎會亂叫](https://img.youtube.com/vi/9FfMzk1t0Zs/mqdefault.jpg)

![Re: [問題] 低速過彎輪胎會亂叫 Re: [問題] 低速過彎輪胎會亂叫](https://cdn-cf-east.streamable.com/image/rwugio.jpg?Expires=1715960689295&Key-Pair-Id=APKAIEYUVEN4EVB2OKEQ&Signature=dNlRnkLXj~5B8HT8yZZ4y9THMCrghGjcviZ9mhHmqjQ613p3zOzvEpph3M2lJ4KdDlz~YE-5FSlXReKBS7c1S3GR6GxKp0vHYA4MIgpgono0~doSfS40rfd2KWrDk7q3YQgkBkScvdCfVBfZOhRdoGvXni010lqe9tTMQ6b4UfDhct~nrxGK1JJcmXu4Y-AuY9srrtJpGXnSViBw-qKS1OwBw0gszUg7Uskcpd2I1AoEgUXmIgD5i~lDD0K1cb0A~4d5kxsG3E46OXWj1F2zL6QBdfueXgU0shEvI0ljWDlQk5tDIaeV-rC~sES4gLaxipey-b1Q-NpoFAVrJAGVnA__)

![[情報] Rolls-Royce Cullinan可能搭載H [情報] Rolls-Royce Cullinan可能搭載H](https://www.supermoto8.net/images/article/f3478200bfea00aa2ef516d7b5864cfe2.jpg)

![[問題] 汽車有衝壓進氣的設計嗎? [問題] 汽車有衝壓進氣的設計嗎?](https://moto7.net/imgs/Resize2520of2520P90045628_highRes1.jpg)

![Re: [新聞] 宛如科幻小說 馬斯克的未來地底隧道亮相 Re: [新聞] 宛如科幻小說 馬斯克的未來地底隧道亮相](https://pic.pimg.tw/ice2006/e80c1fbf5b9c677252f6dad256f576cf.jpg)