Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好

※ 引述《ewings (火星人當研究生)》之銘言:

: ※ 引述《ykjiang (York)》之銘言:

: : 從最基本的原理來說,光達跟雷達就是用來測距,理論上只有一維的資訊

: : 三維的部分是經過一些設計、運算後得到的

: : 反而鏡頭得到的一開始就是二維資訊,然後可以經過運算得到三維的資訊,

: 這邊看完,我的感想只有“供三小?”

: 雷達與光達在原理上是利用掃描的方式,取得距離與向量,本質上資料的維度就是大於二維了。

: 是什麼時候變一維的?如果要這麼瞎扯,那鏡頭裡的CMOS一次也只能讀一個cell的資料,: 一樣得要逐個掃描才能得到二維影像(這個就是所謂的果凍效應的成因),

: 照你的說法,鏡頭不也一樣是一維的?

雷達基本上是機械動作在掃描

初代的光達也一樣,最新的發展小型化後,有搞陣列方式同時發射好幾組雷射,不過

解析度還是個問題

你講的 CMOS 果凍效應,不是 CMOS 的本質,而是數位化後,要將資料放在記憶體,

從記憶體讀取時有先後順序,這基本上是電子式的掃描,跟前面的機械式有差距。

: : 特斯拉更進一步從中取得四維資訊(多的那維是時間軌跡預測)

: 這邊也不知道在供三小

: 在半個世紀前,雷達後處理技術就已經發展出利用比對前後時間目標的變化,預測目標未來位置,

: 並且持續追蹤的技術。甚至還有類似合成孔徑雷達(SAR)那種利用時間與位移積分,: 利用二維掃描形成3維雷達影像的技術。

: 而利用都卜勒濾波技術,甚至不需要比對前後時間的資料,就能直接得到目標的速度,: 在半個世紀前,雷達就能直接利用都卜勒測速,外插推估目標的未來位置。

: 但也沒人講雷達是四維資料的探測器。

你可以搜尋一下,有人就說這個是 4D 雷達

: 而特斯拉的前鏡頭並沒有構成立體視覺,就算加上時間預測,也只能構成2.5D,

去年 10 推出的 FSD Beta 8.1 跟今年三月的 FSD Beta 8.2 已經有立體視覺

預計四月(如果沒延期的話)推出的 FSD Beta 9 會是 Musk 說的 4D 視覺

: (三個定焦鏡只能利用影像模糊的程度大致判斷距離),這也是特斯拉自動駕駛在視覺深度一直為人所詬病的地方。

: : 以目前的技術:

: : 距離方面,光達的精度比較高

: : 平面部分,鏡頭的精度較高,然後鏡頭還可以判斷顏色這個重要資訊

: : 以自動駕駛而言,兩者的精度都超過人眼了

: : 所以關鍵還是在 AI 等其他方面

: 無腦特粉才會覺得只靠鏡頭和AI就行

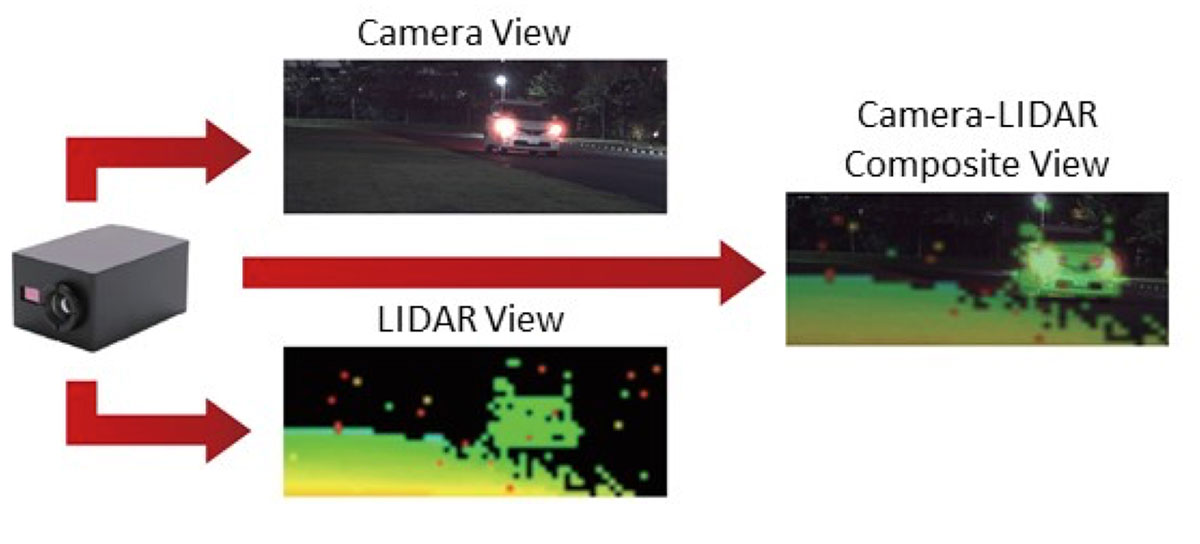

: 真的在搞自動駕駛的,在研究的是怎麼做多感測器的融合。

: https://global.kyocera.com/ces/img/sensing-technology/sec11_img03.jpg

就算如後面推文你說的,特斯拉前向三個鏡頭是不同測交距離的鏡頭,搞不出立體視覺

但你忽略了特斯拉側前方還有兩個前向鏡頭,是完全對稱的測焦距離是一樣的80M以內

--

已回到原PO推文,Tesla主要靠前向三個鏡頭估算距離

原理上任兩個鏡頭拍同一物體呈現不同位置或大小即可

即可估算出距離

vADAS 有些潛在開發廠商,但是傳統車廠不太敢全壓vA

DAS

隨AI進步多鏡頭可以做更多事情 但也別忽略latency

3D sensing可以直接得到深度raw data是其優勢

latency應該都有吧,以目前的原理,

就看這latency是發生在sensor段,還是CPU/GPU段

不只CPU,GPU,前置ISP也有latency

3

笑死,你又把你自己的妄想拿來當證據了,啥“初代光達”! 20年前,連名稱都還沒統一叫Lidar時,就已經在研究使用光電感測器陣列直接生成三維影像了, 一開始研究光達的時候,就有人從雷射全像技術出發,從來沒有你想像的“一維”Lidar : : : 你講的應該是 Rolling Shutter 造成的果凍效應,![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://pic3.zhimg.com/v2-662fc50c422e039867385d43feb2bacb_l.jpg?source=172ae18b)

7

提到光達,沒有人會扯到雷射全像術吧 維基百科介紹 LiDAR 原理時附的動畫如下: Velodyne 出的,早期被用於電動車的 LiDAR ,Waymo 還在用的,結構如下:![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://upload.wikimedia.org/wikipedia/commons/4/4b/Effigy_mounds_lidar.jpg)

1

笑死,光達輸出的資料從來就是三維的,只有一維的叫雷射測距儀。 如果是更早之前還在用LADAR為名的時代,還有更多是利用全像原理,用相位差生成三維資料的技術。 對系統來說,不過感測器是用甚麼原理,輸出的資料格式如果是三維的,那就是三維, 有差別的只是更新率而已。 而光達輸出的一直都是三維資料,即使是平面光達,也是三維資料降維。6

我沒說光達最後的輸出資料不是三維,我只是說初代的光達是用一維的雷射測距,經巧 妙設計後得到三維的資料 : : 你講的應該是 Rolling Shutter 造成的果凍效應, : : CMOS 會採取 Rolling Shutter 有很多因素,例如為了功耗、快門速度、共用元件等 : : CMOS 後來也有 Global Shutter 的設計2

OK, 以雷達波的特性,的確如你說的,可以一個雷達波出去,同時有多組天線接收 這部分跟光達有差異。 : : 你講的 CMOS 果凍效應,不是 CMOS 的本質,而是數位化後,要將資料放在記憶體, : : 從記憶體讀取時有先後順序,這基本上是電子式的掃描,跟前面的機械式有差距。 : 這邊也是看不懂你在講三小![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.technews.tw/wp-content/themes/twentytwelve/library/images/logo.gif)

11

這邊看完,我的感想只有“供三小?” 雷達與光達在原理上是利用掃描的方式,取得距離與向量,本質上資料的維度就是大於二維了。 是什麼時候變一維的?如果要這麼瞎扯,那鏡頭裡的CMOS一次也只能讀一個cell的資料, 一樣得要逐個掃描才能得到二維影像(這個就是所謂的果凍效應的成因), 照你的說法,鏡頭不也一樣是一維的?![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://global.kyocera.com/ces/img/sensing-technology/sec11_img03.jpg)

1

還是不曉得你在供三小 從雷達誕生以來,也從來沒出現過你口中的“一維”雷達 拿二戰裡的德國Lichtenstein雷達來說好了,雷達發射天線是固定在飛機的機首, 也沒有任何的機械機構讓天線搖動或轉動。![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.laserfocusworld.com/files/base/ebm/lfw/image/2020/03/2004LFW_jh_1__2_.5e834778af184.png)

7

直接看實際例子不就好了 在機車海的國家打開FSD 都能正常自輔駕 實際例子有什麼還能質疑的嗎![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.youtube.com/vi/j3n1xBvYkP0/mqdefault.jpg)

9

目前應用的雷達跟光達在量測數據上還是有些不同 [雷達] 參考這篇文章![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://i.imgur.com/AInOO4Db.jpg)

18

首Po這個youtuber將FSD AI看到的畫面結合實際行車畫面 有幾個亮點, 你去觀察對向車道,或是更遠處都可以發現AI都可以清楚知道車子位置在哪 換句話說,FSD用了鏡頭就可以模擬光達的距離偵測了 這個技術已經被特斯拉提出為專利![[分享] 特斯拉FSD beta 來比眼力有沒有比AI好 [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.youtube.com/vi/qRjY55ELYnc/mqdefault.jpg)

25

Re: [新聞] 特斯拉下個版本FSD接近完成最終不需雷達話說這是大概1個月前Musk的推特內容 新聞跟原PO也lag太久..... 推特短短幾行,報導還可以寫這麼多也是不容易 然後更有趣的一點 一邊說使用pure vision,一邊把不專注路況的FSD beta車主排除在外唷XD![Re: [新聞] 特斯拉下個版本FSD接近完成最終不需雷達 Re: [新聞] 特斯拉下個版本FSD接近完成最終不需雷達](https://i.imgur.com/cuaAP2yb.jpg)

17

[情報] Tesla FSD 10.4 beta vs Waymo光達vs視覺 矛盾大對決 出場選手 Waymo : 光達![[情報] Tesla FSD 10.4 beta vs Waymo [情報] Tesla FSD 10.4 beta vs Waymo](https://img.youtube.com/vi/1BsWFzgUBQY/mqdefault.jpg)

3

Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好關於對車輛周遭環境的判別討論還不錯, 但是自動駕駛的進步還有一個關鍵就是駕駛行為, 何時該轉彎?如何轉彎?路口可以往前嚕一點再轉嗎?等等 參考影片: (看看特斯拉如何處理越過多線道左轉)![Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好 Re: [分享] 特斯拉FSD beta 來比眼力有沒有比AI好](https://img.youtube.com/vi/uClWlVCwHsI/mqdefault.jpg)

28

[閒聊] 國道塞車主因之一:中線慢車![[閒聊] 國道塞車主因之一:中線慢車 [閒聊] 國道塞車主因之一:中線慢車](https://img.youtube.com/vi/mGcqK7lTjYU/mqdefault.jpg)

16

Re: [討論] 黃國昌質詢交通部關於柴馬噴水的影片![Re: [討論] 黃國昌質詢交通部關於柴馬噴水的影片 Re: [討論] 黃國昌質詢交通部關於柴馬噴水的影片](https://pgw.udn.com.tw/gw/photo.php?u=https://uc.udn.com.tw/photo/2019/07/12/99/6554594.jpg&s=Y&x=0&y=0&sw=1023&sh=682&sl=W&fw=800&exp=3600)

8

[問題] 沒拖吊場 真沒輒??![[問題] 沒拖吊場 真沒輒?? [問題] 沒拖吊場 真沒輒??](https://i.imgur.com/4P9qxMfb.jpeg)

8

Re: [心得] civic11 & 218i 2AT5

Re: [閒聊] 國道塞車主因之一:中線慢車2

Re: [情報] 懂車帝測試撞擊, 撞了30輛車, 前撞後![Re: [情報] 懂車帝測試撞擊, 撞了30輛車, 前撞後 Re: [情報] 懂車帝測試撞擊, 撞了30輛車, 前撞後](https://i.imgur.com/87RF8Ecb.jpeg)

4

Re: [問題] 2013 forcus 冷氣孔送熱風

[問題] 低里程,適合選油電CC嗎?15

[情報] Rolls-Royce Cullinan可能搭載H![[情報] Rolls-Royce Cullinan可能搭載H [情報] Rolls-Royce Cullinan可能搭載H](https://www.supermoto8.net/images/article/f3478200bfea00aa2ef516d7b5864cfe2.jpg)

3

[問題] 轉速表有沒有可能是快樂錶?15

[問題] 汽車有衝壓進氣的設計嗎?![[問題] 汽車有衝壓進氣的設計嗎? [問題] 汽車有衝壓進氣的設計嗎?](https://moto7.net/imgs/Resize2520of2520P90045628_highRes1.jpg)

3

Re: [新聞] 宛如科幻小說 馬斯克的未來地底隧道亮相![Re: [新聞] 宛如科幻小說 馬斯克的未來地底隧道亮相 Re: [新聞] 宛如科幻小說 馬斯克的未來地底隧道亮相](https://pic.pimg.tw/ice2006/e80c1fbf5b9c677252f6dad256f576cf.jpg)